Arista Networks heeft in samenwerking met NVIDIA AI-datacentertechnologie aangekondigd, om computer- en netwerkdomeinen op één lijn te brengen als één beheerde AI-entiteit. Voor het bouwen van optimale generatieve AI-netwerken die taken sneller verwerken, kunnen klanten AI-clusters op een uniforme wijze configureren, beheren en monitoren. Dat kan voortaan over alle belangrijke infrastructuurbouwstenen, waaronder netwerken, NIC's en servers.

Behoefte aan uniforme controles

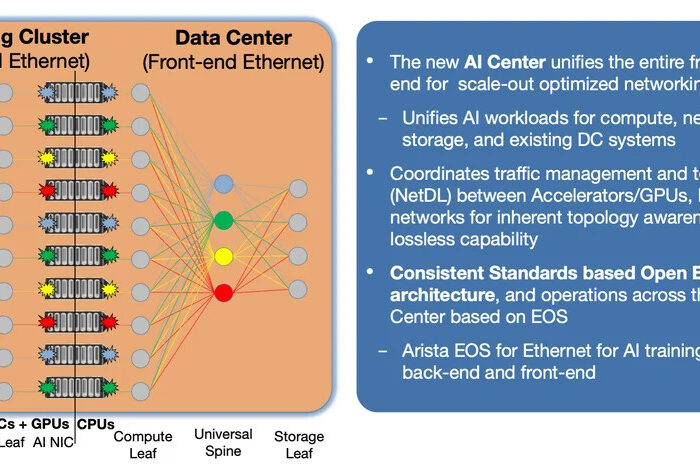

Naarmate AI-clusters en grote taalmodellen (LLM’s) groeien, groeit ook de complexiteit en het volume van andere delen van de totale AI-puzzel. GPU’s, NIC’s, switches, optics en kabels moeten optimaal samenwerken om een holistisch netwerk te vormen. Klanten hebben uniforme controles nodig tussen hun AI-servers die NIC’s en GPU’s hosten, en de AI-netwerkswitches op verschillende niveaus.

Alle elementen zijn van elkaar afhankelijk voor een correcte verwerking van AI-taken, maar werken in de praktijk onafhankelijk van elkaar. Dit kan leiden tot een verkeerde configuratie of verkeerde afstemming tussen onderdelen van het hele ecosysteem, zoals tussen NIC’s en switches. Met als mogelijk gevolg een ongewenste impact op de voltooiing van taken in de tijd, omdat netwerkproblemen moeilijk te diagnosticeren kunnen zijn. Grote AI-clusters vereisen tevens gecoördineerd congestiebeheer om pakketverliezen en onderbenutting van GPU’s te voorkomen, evenals gecoördineerd beheer en monitoring om de computer- en netwerkbronnen tegelijkertijd te kunnen optimaliseren.

Introductie van de Arista AI-agent

De kern van de AI-oplossing is een op Arista EOS gebaseerde agent waarmee het netwerk en de host onderling kunnen communiceren en configuraties kunnen coördineren om AI-clusters te optimaliseren. Met behulp van een externe AI-agent is het EOS op Arista-switches uit te breiden naar rechtstreeks aangesloten NIC’s en servers, om één centraal punt van controle en zichtbaarheid in een AI-datacenter mogelijk te maken als holistische oplossing.

De externe AI-agent die direct op een NVIDIA BlueField-3 SuperNIC wordt gehost, of op de server draait en telemetrie van de SuperNIC verzamelt, stelt EOS in staat om op de netwerkswitch netwerkproblemen op de server te configureren, te monitoren en te debuggen, voor end-to-end netwerkconfiguratie en QoS-consistentie. AI-clusters zijn daardoor als één homogene oplossing te beheren en te optimaliseren.

End-to-end AI-communicatie en -optimalisatie

De nieuwe technologie laat zien hoe een op Arista EOS gebaseerde externe AI-agent het mogelijk maakt het gecombineerde, onderling afhankelijke AI-cluster als één totaaloplossing te beheren. EOS die in het netwerk draait is uit te breiden naar servers of SuperNIC’s via externe AI-agents, om onmiddellijke tracking en rapportage van prestatievermindering of storingen tussen hosts en netwerken mogelijk te maken. Met als gevolg dat de veroorzakers snel kunnen worden geïsoleerd om de impact te reduceren.

Omdat op EOS gebaseerde netwerkswitches continu op de hoogte zijn van de exacte netwerktopologie, maakt het uitbreiden van EOS tot SuperNIC’s en servers met de externe AI-agent een gecoördineerde optimalisatie van end-to-end QoS tussen alle elementen in het AI-datacenter mogelijk. Daarmee is de verwerkingstijd van AI-taken aanzienlijk te verkorten.

Meer lezen