Bijna tweederde van de ondernemers zegt bezig te zijn met kunstmatige intelligentie, ofwel artificial intelligence (ai), maar in de praktijk valt dit tegen. In plaats van ai is dikwijls slechts sprake van eenvoudige analyse. Vooral veel startups bluffen op dit punt om makkelijker investeerders te kunnen aantrekken. Bovendien blijft dure grafische rekencapaciteit vaak onbenut.

Dit stelt Tom van Peer, enterprise pre lead sales Dell Technologies, tijdens de gecombineerde beurzen Infosecurity.nl, Data & Cloud Expo in Jaarbeurs Utrecht. Hij begon zijn presentatie met een terugblik op de geschiedenis van ai. In de begindagen draaide ai om hele slimme algoritmes met zo min mogelijk data. Thans is het omgekeerde het geval. Niet zulke slimme algoritmes worden losgelaten op veel data. Dit komt omdat de data-opslag goedkoop is geworden terwijl ook de computerkracht haast niet aan te slepen is.

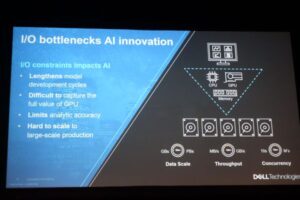

Ondanks de enorme opslagmogelijkheden doen nieuwkomers in de ai er verstandig aan met iets kleins te beginnen, stelt Van Peer. Begin met weinig data, is zijn advies. Want als je te grootschalig van start gaat, kan het misgaan. Dan ontstaan bottlenecks. Van Peer ziet vaak dat hele dure gpu’s (graphics processing units) tijdens het trainen van modellen en algoritmes de helft van hun tijd of meer niets staan te doen. De storage die de trainingsdata moet leveren, is dan niet snel genoeg.

Van Peer kent gevallen waarbij servers met 10 gpu’s van 10.000 euro per stuk en ssd’s maar 20 procent van de tijd nuttig werk doen. 80 procent van de tijd moeten ze wachten op data. Het ontbreekt dan aan voldoende bandbreedte. Als het systeem volloopt kan de vertraging enorm oplopen. Dit kan plotseling gebeuren.

Video-analyse vormt vaak een uitdaging.

Met hoge bandbreedte, veel iops en een lage latency vallen problemen te voorkomen. De benodigde capaciteit hangt af van het type ai. Generieke machine learning, een soort statistiek 2.0, stelt andere eisen dan Deep Learning gebaseerd op neurale netwerken. Bij dit laatste kan sprake zijn van vele tientallen lagen. Heel veel processen draaien dan tegelijk, wat hoge eisen stelt aan de throughput. Bij video-analyse moet het systeem worden gevoed met heel veel plaatjes. In zo’n situatie kan de latency snel oplopen. Er zijn op dit moment servers met 72 gpu’s die 52.000 plaatjes per seconde lezen. Als een plaatje 64 kB is moet aan meta data bij zo’n grote hoeveelheid al gauw 3GB per seconde worden verwerkt. Van Peer: ‘De meeste storage systemen kunnen daar slecht tegen.’

Video-analyse is een hele uitdaging. Dell werkt aan een ai-project met een niet nader genoemd ziekenhuis dat chirurgen vertelt waar het beste kan worden gesneden. Daartoe worden alle video’s van kijkoperaties aan een analyse onderworpen. Ai vervult dan een adviserende rol. De chirurg krijgt een AR-bril (augmented reality) op met een laagje informatie die aangeeft of hij in het juiste gebied zit te snijden.

Van Peer onderstreept het belang van eigen data in de gezondheidszorg. Als die ontbreken wordt het lastig een eigen ai-strategie te ontwikkelen. Data van Amerikaanse patiënten zijn minder geschikt. De VS kennen een andere samenstelling van de bevolking. Ook is de gemiddelde Amerikaan veel zwaarder.